خلال معرض الإلكترونيات الاستهلاكية CES 2025، طرحت AMD أول معالج حاسوب ذكي يعمل بنظام Windows يعمل بنظام Llama 70b محليًا. بفضل دعم llama.cpp وLM Studio، شكّلت هذه الإمكانية ميزةً أساسيةً لنشر LLM في أنظمة Windows الرقيقة والخفيفة.

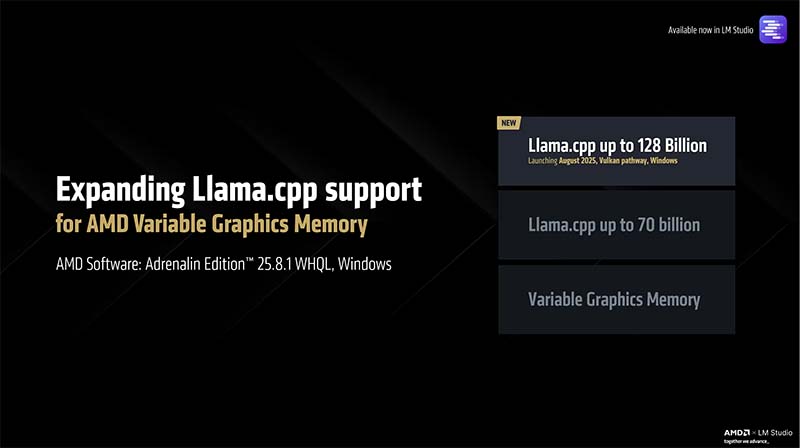

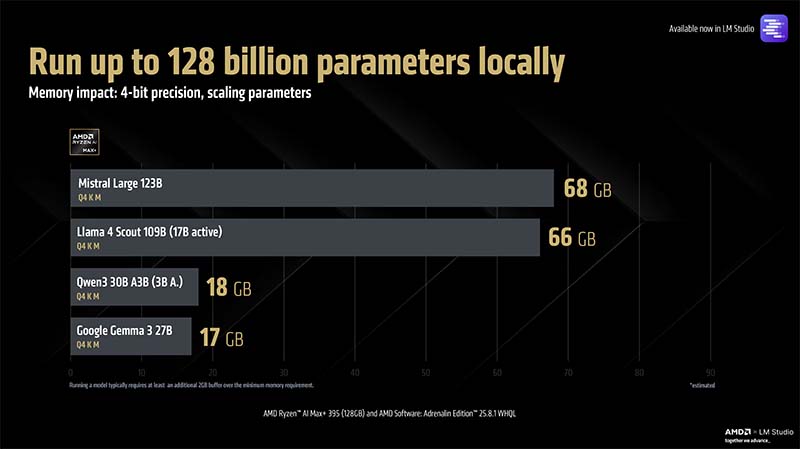

وتعلن الشركة اليوم عن ترقية هامة لذاكرة الرسومات المتغيرة من AMD لتمكين ما يصل إلى 128 مليار معلمة في Vulkan llama.cpp على نظام Windows. ستُدمج هذه الترقية في برامج تشغيل Adrenalin Edition 25.8.1 WHQL القادمة، مما يُتيح معالجة أحمال عمل الذكاء الاصطناعي التي تتطلب ذاكرة أكبر، ويمكنها الاستفادة الكاملة من ذاكرة VGM سعة 96 جيجابايت المتوفرة على Ryzen AI MAX+ 395 سعة 128 جيجابايت على نظام Windows.

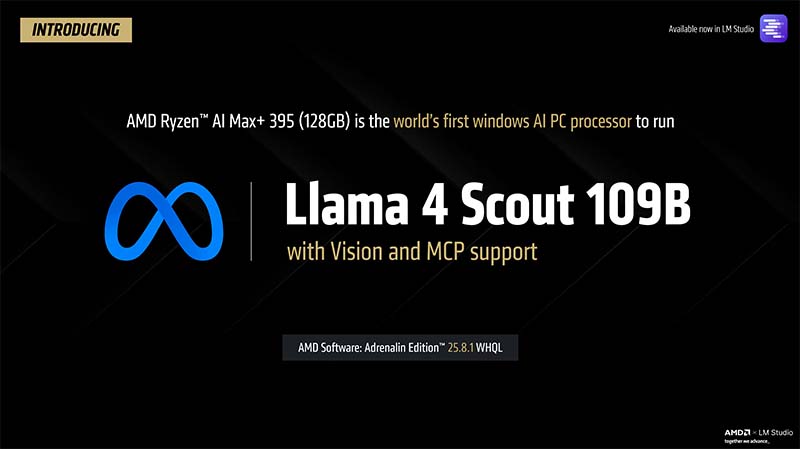

هذه الترقية الرئيسية للقدرات تجعل معالج AMD Ryzen AI Max+ 395 (128 جيجابايت) أول معالج حاسوب ذكي يعمل بنظام Windows في العالم يعمل بنظام Meta Llama 4 Scout 109B (17 جيجابايت نشط) مع دعم الرؤية الكاملة وMCP.

يُعدّ هذا إنجازًا هامًا يُرسّخ مكانة AMD كشركة وحيدة تُقدّم حلولًا متكاملة من السحابة إلى العميل لأحمال عمل الذكاء الاصطناعي المتطورة. ما كان متاحًا سابقًا فقط على أجهزة مركز البيانات، أصبح الآن متاحًا بمواصفات رفيعة وخفيفة. يُمكنك معرفة المزيد حول تشغيل Meta Llama 4 على Instinct هنا.

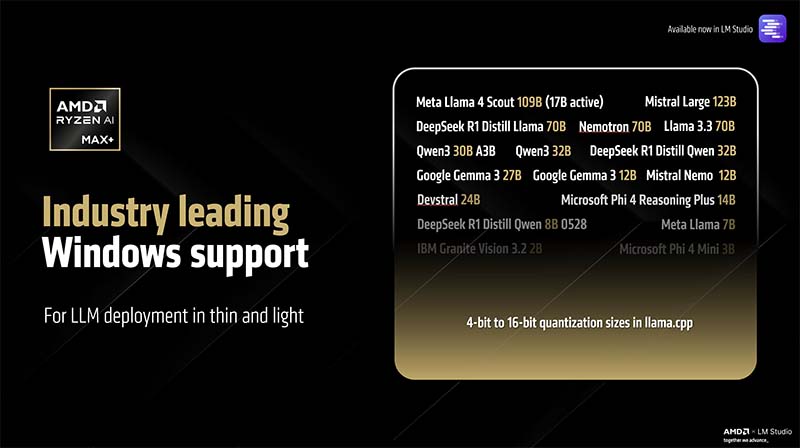

هذا يُعزز ريادة AMD Ryzen AI Max+ كمنصة ويندوز رائدة في مجال نشر LLM في الأنظمة الرقيقة والخفيفة. من خلال llama.cpp، يدعم معالج AMD Ryzen AI Max+ 395 (128 جيجابايت) جميع الطرازات، من طرازات 1B الصغيرة إلى الطرازات الضخمة مثل Mistral Large، مع خيارات تكميم مرنة عبر GGUF.

لأن Meta Llama 4 Scout هو نموذج مزيج من الخبراء، يتم تفعيل 17 مليار معلمة فقط في كل مرة (مع ضرورة حفظ جميع المعلمات البالغ عددها 109 مليارات معلمة في الذاكرة – لذا فإن البصمة هي نفسها نموذج كثيف يبلغ 109 مليارات معلمة). هذا يعني أنه يمكن للمستخدمين توقع معدل إخراج سهل الاستخدام للغاية في الثانية (بالنسبة لحجم النموذج) يصل إلى 15 رمزًا في الثانية.

هذا من شأنه أن يسمح باستخدام Llama 4 Scout كمساعد ذكاء اصطناعي عالي الكفاءة أثناء التنقل. إذا رغب المستخدم في التبديل إلى نموذج أصغر (وأسرع)، فيمكنه القيام بذلك أيضًا (يرجى ملاحظة أن الأداء سيرتبط بعدد المعلمات النشطة لنماذج MoE وجميع معلمات النماذج الكثيفة).

استخدام نماذج ذات أحجام معاملات أعلى، مع ثبات جميع العناصر الأخرى، يزيد من جودة مخرجاتها، كما يتيح معالج AMD Ryzen AI Max+ 395 (128 جيجابايت) مرونة كاملة في تشغيل معظم النماذج التي تدعمها llama.cpp.

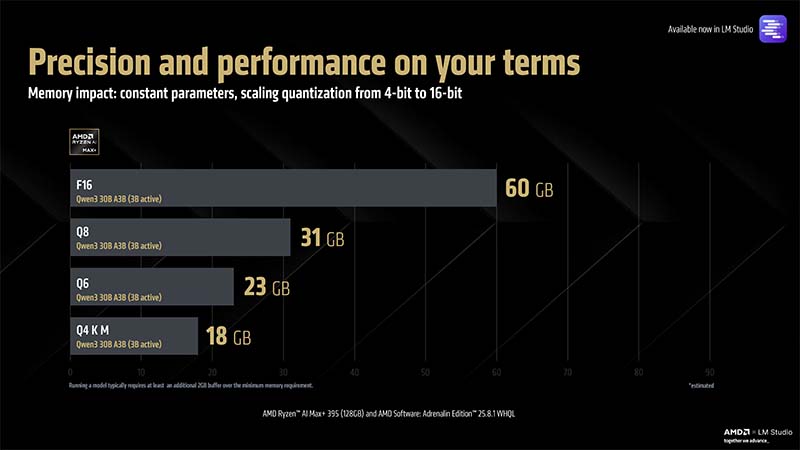

من ناحية أخرى، يمكن أن تؤدي زيادة التكميم (مع الحفاظ على ثبات النموذج) إلى مخرجات ذات جودة أعلى (مع عوائد متناقصة)، وإذا كان المستخدم مستعدًا للموازنة بين الأداء، فإن منصة AMD Ryzen AI Max+ تتمتع بقدرة ذاكرة تدعم نماذج تصل إلى 16 بت من خلال llama.cpp.

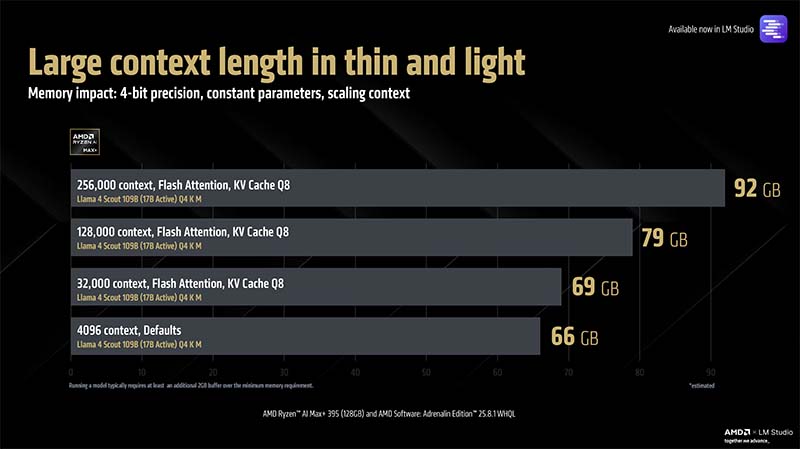

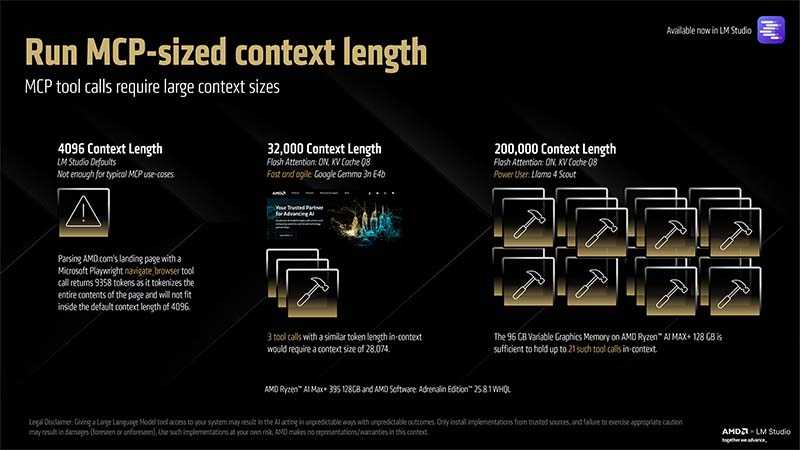

أحد المتغيرات التي لم تحظَ باهتمام كبير خلال الأشهر القليلة الماضية هو حجم سياق النموذج. السياق الافتراضي، على سبيل المثال، في LM Studio مضبوط على 4096 رمزًا. يمكن اعتبار الرمز مكافئًا تقريبًا لكلمة واحدة. مع تحول حالات استخدام LLM بشكل متزايد إلى مهام تعتمد على الرموز بشكل كبير – سواء من خلال RAG أو MCP – فإن وجود أطوال سياق أكبر يدعمها مثيل LLM المحلي الخاص بك أمر بالغ الأهمية.

معالج AMD Ryzen AI Max+ 395 (128 جيجابايت) مع برنامج AMD: إصدار Adrenalin 25.8.1 WHQL لا يقتصر على تشغيل Meta’s Llama 4 Scout فحسب، بل يعمل أيضًا على طول سياق يبلغ 256,000 (Flash Attention ON، KV Cache Q8). يسمح هذا بحفظ عدد كبير من الرموز المميزة في السياق، ويمكّن من سير عمل وكلاء قوي.

على سبيل المثال، هذا العرض التوضيحي لـ SEC EDGAR MCP، حيث يقوم LLM باستخراج أحدث تقرير ربع سنوي من AMD وتلخيصه. بين عملية النقل ذهابًا وإيابًا وتنزيل البيانات من SEC، تطلب الإجراء حفظ 19,642 رمزًا في السياق، وهو أمرٌ سيفشل ببساطة عند الحد الأقصى الافتراضي لنافذة السياق وهو 4096.

مثال آخر، هذه المرة، استعلام من قاعدة بيانات ARXIV، يُظهر النموذج الذي يستعلم عن أحدث ورقة بحثية منشورة في علم الكونيات، ثم يُلخص الورقة البحثية في بضعة أسطر فقط عند الطلب. استغرق هذا الإجراء 21,445 رمزًا من البداية إلى الإخراج.

يرجى ملاحظة أن العروض التوضيحية أعلاه هي عروض توضيحية لإجراء واحد لحالة استخدام محددة، وقد تتطلب بعض سير العمل عددًا كبيرًا من الرموز المحفوظة في السياق، أو إجراءات متعددة تعمل بالتتابع، كل منها يستدعي أدوات متعددة. لهذا السبب، يُمثل MCP استنزافًا كبيرًا لموارد السياق، وستتطلب سير العمل الوكيلة كميات كبيرة من أطوال السياق لتكون مفيدة.

لذا، سيرغب المستخدم العادي الذي يحتاج أحيانًا إلى إمكانية MCP في ضبط طول السياق إلى 32,000 (وهو الحد الأقصى النموذجي لبعض نماذج LLM) واستخدام نموذج خفيف الوزن، بينما سيحتاج المستخدمون المحترفون إلى نماذج LLM متطورة تدعم أطوال سياق كبيرة، بالإضافة إلى أجهزة لاحتواء هذا القدر من السياق في الذاكرة (مثل AMD Ryzen AI Max+ 395 128GB).

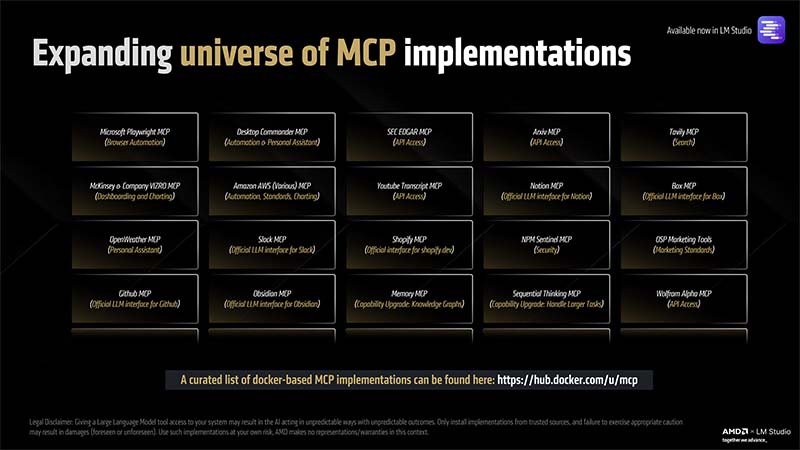

يشهد عالم MCP توسعًا مستمرًا، وخلال العام المقبل، سيزداد استخدام وكلاء الذكاء الاصطناعي في الاستدلال المحلي. كما يأخذ مطورو النماذج، مثل Meta وGoogle وMistral، استدعاء الأدوات في الاعتبار عند إجراء عمليات التدريب، بحيث تصبح النماذج، مع مرور الوقت، أكثر مهارة في فهم الأدوات واستدعائها، مما يمهد الطريق لـ LLM كمساعد شخصي في مثيل محلي.

وتتوفر الاجهزة والانظمة العاملة بمعالج AMD Ryzen AI Max+ (128GB) لدى شركاء AMD التاليين: